Kunstig nevralt nettverk

Kunstig nevralt nettverk, eller bare nevralt nettverk, brukes som benevnelse på en sterkt forenklet etterligning av biologisk nervevev fra hjernen eller det sensoriske system. Metodene og algoritmene bruker inspirasjon fra biologisk nervevev, men uten å være eksakt kopi. Slike kunstige nevrale nettverk stod i spissen blant de nye biologiinspirerte teknikkene innen databehandling som vokste frem på 1970-tallet, selv om metodegrunnlaget kan føres tilbake til Frank Rosenblatt sin forskning på perceptroner ved Cornell Aeronautical Laboratory i 1957.[1]

Frasen nevralt nettverk refererer som oftest til kunstige nevrale nettverk på en klassisk digital form, men det finnes varianter som går ut over de kjente metodene fra biologien. I biologien er det også metoder som vanskelig lar seg kopiere i kunstige implementasjoner. Hvis etterligningen er inspirert av biologien snakker en ofte om Nevromorf prosessering. Det er flere mulige grenser som kan trekkes mellom slike implementasjoner. En kan dele i digitale implementasjoner med mykvare og maskinvare på ene siden og analoge implementasjoner på den andre, en kan dele i nettverk som har liten eller ingen tidsdimensjon vs nettverk hvor tidsdimensjonen er vesentlig, en kan dele i nettverk med lineære noder vs nettverk med ulineære noder (lineære overføringsfunksjoner eller aktiveringsfunksjoner vs ulineære), en kan dele i ettlagsnettverk vs flerlagsnettverk (dyp læring aka «deep learning»), en kan dele i forovermatede nettverk vs tilbakematede nettverk, en kan dele i homogene nettverk med like noder vs heterogene nettverk, og så videre.

De viktigste anvendelsene er i 2018 innen selvlærende flerlagsnettverk med ulineære noder, hvor læringen eventuelt spisses med styrt læring. Slike anvendelser vil ofte bli initialisert til en startverdi ut ifra et utagget treningsett (apriori kunnskap) hvoretter det brukes selvlærende algoritmer for å få nettverket til å følge eller tilpasse seg et nytt tagget treningsett (aposteriori kunnskap). En slik transfer learning forutsetter at en kan avgjøre hva som er riktig respons for det taggede treningsettet.

Bakgrunn rediger

Den originale inspirasjonen til nevrale nettverk kom fra observasjon av sentralnervesystemet, med nerveceller, aksoner, dendritter og synapser er «prosessoren» i levende vesener. Inspirasjon til noen av bestanddelene er også fra forskning på levende vesener som har et nervesystem, men som mangler et fullt utviklet sentralnervesystem. Metodene er generelle og ikke spesifikt knyttet til eksistensen av et emulert sentralnervesystem, selv om et overordnet mål for mange forskningsarbeider er å nå frem til noe slikt.

Siden forskning på nervenes funksjon fortsatt er på et tidlig stadie der det finnes mange ubesvarte spørsmål og abstraksjonsnivå, så finnes det ingen entydig definisjon av hva som er et kunstig nevralt nettverk. En løst definert fellesnevner er at slike består av et nettverk av enkle prosesseringselementer som utfører en globalt kompleks handling basert på koblinger mellom prosesseringselementer og disses parametere. Det er vanlig å bruke algoritmer for maskinlæring til å balansere og tilpasse parametrene som i denne sammenheng typisk kalles «vekter».

Uttrykket kunstige nevrale nettverk blir i hovedsak brukt om nevrale nettverksmodeller nyttet i statistikk, kognitiv psykologi og kunstig intelligens.

I moderne programvareutvikling har man tatt i bruk en mer praktisk tilnærming basert på statistikk og signal prosessering. Prinsippet om ikke-lineær, distribuert, parallell og lokal prosessering og adapsjon blir ivaretatt i disse systemene, selv om mange av elementene fra biologi ikke finnes i disse systemene.

Oppbygning rediger

Et nevralt nettverk er bygget opp av nevroner, som i sin enkleste og eldste form også kalles perceptrons, og bindingene mellom disse og påtrykk fra foregående lag. Bindinger er i noen sammenhenger brukt om de enkelte vektene i nettverket, i andre sammenhenger er de brukt om de enkelte utganger fra foregående lag. I mange typer nevrale nettverk er det veldefinerte inngangsnoder (inputvector), som vektes og prosesseres med overføringsfunksjonen (aktiveringsfunksjonen), hvoretter de leveres til veldefinerte utgangsnoder (outputvector). Disse blir gjerne kalt Feed-forward nettverk hvis de ikke har læring aktivert.

Det snakkes ofte om inngangsnoder og utgangsnoder som ikke har noen selvstendig overføringsfunksjon, samtidig som det snakkes om prosesserende noder i laget. Dette kan være forvirrende. Det er enklere å se på dette som en inngangsvektor og en utgangsvektor, hvor en matrise bringer inngangsvektoren over på formen til utgangsvektoren.

I det etterfølgende beskrives et forovernett (feed foreward net). Hvis en legger til læring så vil dette fungere som et nett rettet motsatt vei og som propagerer feilverdier. I praktisk bruk er det imidlertid vanligere å flytte selve lærealgoritmen (backpropalgoritmen) inn i enheten som definerer det kunstige nevronet.

Nevron rediger

Nevrale nettverk består av et stort antall relativt enkle noder, alle kjører den samme algoritmen. Opprinnelig var disse ment som en emulasjon av en enkelt nervecelle eller nevron. Hvert nevron kommuniserer med et subset av de andre kunstige nevronene i nettverket.[2] Hver input et nevron får fra andre nevroner har en vekt assosiert. Vekten sier hvor viktig denne inputen er for nevronet.[3] Nevroner har også en aktiveringsfunksjon som prosesserer summen av påtrykket, og et tilhørende bias. Bias fungerer som en terskel i et perceptron. Det er i noen tilfeller enklest å skille ut bias i en egen parameter, mens det i andre tilfeller er enklere å se på bias som et konstantpådrag i en av inngangsnodene.

Aktiveringsfunksjon rediger

I nevrale nettverk beskriver aktiveringsfunksjonen outputoppførselen til et nevron. De fleste nevrale nettverk starter med å beregne den vektede summen av alle inngangene. Denne verdien (total net input) blir deretter vanligvis transformert ved hjelp av overføringsfunksjonen (aktiveringsfunksjon, squashing function). En av de enkleste overføringsfunksjonene sier kun at hvis total net input er mindre enn 0, er output fra nevron 0, ellers output 1.[4] Denne overføringsfunksjonen er tett opp mot funksjonen som finnes i enkelte former for biologisk nervevev, hvor en sier at nerven «fyrer» når potensialet kommer opp i et gitt nivå. Andre viktige funksjoner er en identitetsfunksjon, eller en slik med øvre og/eller nedre skranke. Slike funksjoner er så tilnærmet med en eller flere logaritmiske funksjoner eller endog en hyperbolsk funksjon. Valget av den siste kommer av disses egenskaper i forbindelse med maskinlæring.

Vekt rediger

En vekt, i et kunstig nevralt nettverk, er en parameter tilknyttet tilkoblingen mellom et nevron M, til et annet nevron N. Dette er omtrent det samme som bindingen til en synapse i et biologisk nevron. Vekten bestemmer hvor mye nevron N bryr seg om aktiveringen N får fra nevron M, eller hvor mye av pådraget fra N som når frem til M.[5]

I noen spesielle former for nettverk brukes det også ulineære overføringsfunksjoner istedenfor lineær vekting, men slike nettverk kan skrives om til to eller flere koblede nettverk med ulike overføringsfunksjoner. Slike nettverk brukes vanligvis i forbindelse med problemstillinger hvor en ønsker separasjon av datasett og ikke bare dekorrelering, det vil si dekorrelering over høyereordens komponenter.

Bias rediger

I feedforward og noen andre nevrale nettverk er hvert nevron tilkoblet et fast bias, som også kan beskrives som et konstantpådrag, via en trenbar vekt. Dennes eksaktverdi er uvesentlig, men blir ofte satt til 1 eller -1. Fortegnet er uvesentlig om det kan trenes negative vekter. Dette gjør at hver skjulte enhet og outputenhet får et trenbart threshhold. Hvis eksaktverdien er -1 så blir threshold verdien til vekten knyttet til nevronets bias.

Perceptron rediger

Et perceptron er et enkelt kunstig nevron som har en aktiveringsfunksjon som tar total net input og gir 1 hvis dette er over en grense (treshold), eller 0 hvis ikke.[1] I noen sammenhenger er det praktisk å behandle alle nevrons som en perceptron.

Det er litt forskjell i litteratur med hensyn på hva som kalles et perceptron. I noen tilfeller brukes begrepet om et enkelt kunstig nevron, i andre tilfeller om et helt lag av slike, i noen tilfeller om et nevron med lineær overføringsfunksjon, i andre tilfeller med en enkelt terskel.

Grensefunksjon (threshold function) rediger

Output fra et perceptron er 0 hvis total net input til perceptronet er mindre enn grensen(threshold) T, ellers er output 1. [6]

Enkelt lag forovermatet nevralt nettverk rediger

Et nettverk der alle input er koblet direkte til output blir kalt et ettlagsnettverk (single layer network) eller perceptron nettverk. Igjen er bruk av perceptron litt uklart, for normaltolkingen vil være at hver node også har egenskapene til en ren thresholdfunksjon. Når nodene implementerer en 'treshold' funksjon så kan vi se på perceptronene som en representasjon av en boolsk funksjon.[7] Det er en del boolske funksjoner et slikt ettlags perceptron nettverk ikke kan representere.

Læringsalgoritme rediger

For et perceptron nettverk kan det brukes en enkel læringsalgoritme for å trene vektene utfra et datasett. For flerlagsnettverk må en bruke tilbakepropageringsalgoritmer for læring. Læringsalgoritmen som blir presentert her er den samme for alle output-nevroner, derfor blir algoritmen beskrevet for ett enkelt nevron i isolasjon.

- Vi definerer noen variabler

- funksjon for output fra en perceptron med input vektor .

- er bias termen.

- er treningsdatasettet bestående av verdier, der er den -dimensionale input vektoren og er den ønskede utgangsverdien for den gitte inngangsvektoren.

- Vi gir pådraget på nodene slik at

- er verdien av for inngangsnode og løpenummer i treningssettet.

- er tilsvarende pådraget for bias i datasettet.

- For å representere vektene

- er verdien for nummer i vektvektoren, som skal multipliseres med input node nummer , eller for et fullt lag så vil dette være matrisen alle innganger vektes med.

En ekstra dimensjon, med indeks , kan bli lagt til alle input vektorer, med , i så fall vil erstatte bias termen.

For å vise hvordan endres over iterasjonen som en løpetid brukes

- som er vekten på tidspunktet .

- som er læringsraten, der .

Med for høy læringsrate vil perceptronet periodisk variere over og under løsningen. En mulig forbedring for å få det til å konvergere er å bruke med n=1 i begynnelsen og inkrementere med 1 når en loop i læringen blir funnet. Dette implementerer et fall (decay) i læreraten for å sikre konvergens.

Stegene i læringsalgoritmen rediger

1. Initialisering av vekter og 'threshold'. Vekter kan initialiseres ved å sette hver vekt node til 0 eller til en lav tilfeldig verdi.

- 2a. Kalkuler det faktiske output:

- 2b. Tilpass vektene:

- , for all nodes .

Steg 2 er repetert til feilen i en iterasjon er mindre enn en brukerspesifisert grense , eller etter at et predefinert nummer av iterasjoner har blitt gjennomført. Legg merke til at algoritmen tilpasser vektene øyeblikkelig etter at steg 2a og 2b er utført på et par i treningsdatasett istedenfor å vente på at alle parene i et treningsdatasett har blitt evaluert.

Separerbarhet og konvergering rediger

Novikoff (1962) beviste at perceptron algoritmen vist ovenfor konvergerer etter et endelig nummer av iterasjoner hvis datasettet er lineært separerbart. Hvis datasettet ikke er lineært separerbart vil ikke algoritmen overfor konvergere.

Flerlags forovermatet nevralt nettverk rediger

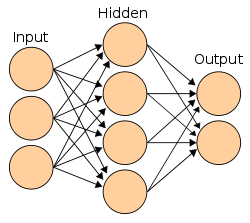

Nevrale nettverk med flere lag blir som oftest referert til som Flerlags forovermatet nevralt nettverk. Der den mest vanlige versjonen har et inputlag, et skjult lag og et outputlag, slik som figuren overfor (Fig. 1) viser. I dette tilfellet er ikke inngangsvektoren og utgangsvektoren vist. Man kan tenke seg at hver skjulte enhet er et perceptron som representerer en grensefunksjon fra inputlaget. Videre kan man tenke seg at en outputenhen er en begrenset(thresholded) lineær kombinasjon av flere skjulte enheter. Med et stort nok skjult lag kan et nevralt nettverk med kun ett skjult lag representere alle kontinuerlige funksjoner, med to lag kan til og med ukontinuerlige funksjoner representeres.[7] Hvis overføringsfunksjonene kan velges ideelt så blir også antall skjulte noder begrenset og endelig. Forutsetningene for at dette skal skje er aldri tilstede i praksis.

Læringsmetode rediger

Læringsalgoritmene for flerlags forovermatede nevrale nettverk er sammenlignbare med algoritmene for perceptronettverk, en variasjon av disse er vist over. En av hovedforskjellene er at vi kan ha flere utganger, slik at vi har en utgangsvektor istedenfor en enkeltverdi, hvert eksempel har også en utgangsvektor . Hovedforskjellen mellom enkeltlags og flerlags er at feilen til output ( ) er tydelig, mens feilen til det skjulte laget forblir ukjent siden treningsdatasettene ikke har noe data om hva de skjulte nodene skal gi som output.[7] Feilen fra utgangen kan imidlertid propageres gjennom nevronet ved å invertere overføringsfunksjonen og dermed fordeles på feil introdusert fra de enkelte pådrag. En slik tilbakepropagering kan gjøres gjennom mange skjulte lag, men som det viser seg, med stadig lavere lærerate.

Algoritmen rediger

En generell tilbakeforplantningsalgoritme (back-propagation algorithm):

Initialisering: vektene til det nevrale nettverket får små tilfeldige verdier

Gjør:

For alle eksempler e i treningsdatasettet:

= output fra bruk av inputs mot vektene i nettverket sine verdier

= output for e fra treningsdatasettet

Kalkuler feilen ( ) for outputenhetene

Regn ut for alle vektene fra det skjulte laget til outputlaget

Regn ut for alle vektene fra inputlaget til outputlaget

Oppdater alle vektene i nettverket

Til: Alle eksemplene er klassifisert korrekt eller til et stoppkriterium blir møtt

Returner nettverket

Referanser rediger

- ^ a b Rosenblatt, Frank (1957), The Perceptron--a perceiving and recognizing automaton. Report 85-460-1, Cornell Aeronautical Laboratory.

- ^ Millington, Ian (2009). Artificial intelligence for games (2nd ed. utg.). Burlington, MA: Morgan Kaufmann/Elsevier. ISBN 978-0-12-374731-0.

- ^ «The Machine Learning Dictionary».

- ^ «The Machine Learning Dictionary».

- ^ «The Machine Learning Dictionary».

- ^ «The Machine Learning Dictionary».

- ^ a b c Russell, Stuart J. (2003). Artificial intelligence : a modern approach ; [the intelligent agent book] (2. ed., internat. ed. utg.). Upper Saddle River, NJ [u.a.]: Prentice Hall. ISBN 0130803022.